HPCPack2012R2

This reference provides cmdlet descriptions and syntax for all HPC cluster-specific cmdlets that are available in Microsoft HPC Pack 2012 R2, Microsoft HPC Pack 2012, and HPC Pack 2008 R2. The HPC cmdlets provide an alternative to most actions that you would otherwise perform with command-line commands, HPC Cluster Manager, or HPC Job Manager.

For information about using HPC PowerShell, see Appendix 6: Using HPC PowerShell in the TechNet library.

For information about using Windows PowerShell, see Windows PowerShell (TechNet) in TechNet.

For information about built-in Windows PowerShell cmdlets, see Windows PowerShell Core Cmdlets in TechNet.

HPCPack2012R2

Adds device drivers to all of the operating system images in an HPC cluster.

Adds nodes to node groups.

Adds an operating system image to the image store for an HPC cluster.

Adds the iSCSI storage array at the specified management IP address to an HPC cluster.

Adds a domain account to the HPC cluster as a member in a cluster role.

Adds a set of Azure nodes to the HPC cluster.

Adds a resource pool to an HPC cluster.

Creates a task and adds it to a job.

Adds custom diagnostic tests to the set of diagnostic tests that administrators can run on the HPC cluster.

Adds unmanaged compute resources to the cluster as a compute node.

Assigns or reapplies a node template to a node.

Copies a job template.

Creates a node template by making a copy of an existing node template.

Saves information about the DHCP reservations.

Saves information about a job in an XML file.

Creates an XML-based representation of a node template and stores it in a file.

Exports information about compute nodes to an XML file.

This cmdlet is deprecated and was removed in MicrosoftВ® HPC Pack 2012. Copies the WCF log files that contain the traces for an SOA session from each of the compute nodes to a single location so that you can view the log files with Service Trace Viewer.

Exports the settings for a task to an XML file.

Exports the test results for the specified diagnostic test run to the specified directory.

Gets an overview of some metrics for the specified HPC cluster, including the number of nodes, jobs, and tasks in various states on the HPC cluster.

Gets the cluster-wide properties for an HPC cluster.

Gets device drivers.

Gets operating system images for an HPC cluster.

Gets HpcIScsiStorageArray objects.

Gets the credentials for submitting jobs.

Gets the job history data for all finished, canceled, and failed jobs.

Gets information for one or more specified job templates, or for all job templates if none are specified.

Gets the ACL for a job template.

Gets a member for the HPC cluster.

Gets metrics that HPC Cluster Manager uses in the heat maps for the nodes and the monitoring charts.

Gets the current value of metrics that HPC Cluster Manager uses in heat maps for nodes and monitoring charts.

Gets the values for a specified metric during the specified time period.

Gets network interfaces on the head node.

Gets the current network topology for the HPC cluster.

Gets nodes in the HPC cluster.

Gets the history of changes to the state of the nodes in the HPC cluster for the specified time period.

Gets a node template for an HPC cluster.

Gets the log and substeps for the specified operation.

Gets a resource pool.

Gets a task or subtask for a job.

Gets diagnostic tests for the HPC cluster.

Gets detailed information about a diagnostic test.

Gets detailed information about the results of a run for a diagnostic test.

Imports a job template from an XML file.

Imports metrics from the specified XML file to create new metrics or overwrite existing metrics that HPC Cluster Manager uses in the heat maps for the nodes and the monitoring charts.

Imports node template XML files.

Imports nodes from the lists of nodes in one or more specified node XML files, and adds the nodes to the HPC cluster.

Runs the specified diagnostic tests on one or more specified nodes.

Creates a node group.

Creates an operating system image and adds it to the image store for an HPC cluster.

Creates a job, or creates a copy of an existing job.

Creates a node template and optionally associates an operating system image with the node template.

Generates an HPC soft card certificate.

Removes one or more Azure nodes from an HPC cluster.

Removes a device driver.

Removes the association between one or more specified node groups and one or more specified nodes.

Removes operating system images from the image store for an HPC cluster.

Removes the specified iSCSI storage array from the HPC cluster.

Deletes cached credentials that the job scheduler uses to submit jobs.

Deletes a job template.

Removes members from the HPC cluster or from specified roles.

Removes metrics from the set of metrics that HPC Cluster Manager uses in the heat maps for the nodes and the monitoring charts.

Removes the entry for one or more nodes from the HPC cluster management database.

Removes a set of Azure nodes from an HPC cluster.

Deletes node templates from the HPC cluster.

Removes a resource pool.

Deletes the cached credentials for users that SOA clients use to create SOA sessions.

This cmdlet is deprecated and was removed in HPC Pack 2012. Removes the Windows Communication Foundation (WCF) log files that contain the traces for the specified service-oriented architecture (SOA) session from the compute nodes.

Removes the diagnostic test with the specified alias from the HPC cluster.

Clears the cached credentials that the HPC Diagnostics Service uses to run diagnostic tests.

Clears the alert icon for diagnostic test runs.

Copies a base-node operating system image from a Windows image (.wim) file to an Internet SCSI (iSCSI) storage array.

Restarts a node that is already turned on.

Sets cluster-wide properties.

Modifies the name or description of a node group.

Sets an iSCSI storage array for an HPC cluster.

Sets the properties of the specified job.

Sets the credentials for submitting jobs.

Sets the ACL on a job template.

Changes the properties for a node.

Sets the state a node.

Sets the weight of a resource pool.

Sets the credentials for creating SOA sessions.

Sets the properties for a task.

Sets the credentials for running diagnostic tests.

Turns off one or more nodes.

Starts Azure nodes.

Turns on nodes by using an Intelligent Platform Management Interface (IPMI) script.

Starts a set of Azure nodes.

Stops a set of Azure nodes.

Cancels the specified operation and makes the best possible attempt to revert the operation, if the operation is still running.

Cancels a task or subtask.

Cancels a diagnostic test if it is still running.

Submits or re-queues jobs to the HPC cluster.

Validates that the head node of the HPC cluster can communicate with an iSCSI storage array.

Windows hpc pack 2012 r2

Important

We have moved the project to Microsoft Azure official account in github (@Azure).

This repository will not be updated anymore.

This project welcomes contributions and suggestions. Most contributions require you to agree to a Contributor License Agreement (CLA) declaring that you have the right to, and actually do, grant us the rights to use your contribution. For details, visit https://cla.microsoft.com.

When you submit a pull request, a CLA-bot will automatically determine whether you need to provide a CLA and decorate the PR appropriately (e.g., label, comment). Simply follow the instructions provided by the bot. You will only need to do this once across all repositories using our CLA.

This project has adopted the Microsoft Open Source Code of Conduct. For more information see the Code of Conduct FAQ or contact opencode@microsoft.com with any additional questions or comments.

The following templates create an HPC Pack cluster in an existing Active Directory Domain

Template 1: Cluster for Windows workloads in an existing Active Directory Domain

This template deploys an HPC Pack 2012 R2 cluster for Windows HPC workloads in an existing Active Directory Domain forest. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Windows compute nodes. Use this template if you have a virtual network with Express Route configured and you want to join the cluster to your on-premises Active Directory Domain.

Template 2: Cluster for Linux workloads in an existing Active Directory Domain

This template deploys an HPC Pack 2012 R2 cluster for Linux HPC workloads in an existing Active Directory Domain forest. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Linux compute nodes. Use this template if you have a virtual network with Express Route configured and you want to join the cluster to your on-premises Active Directory Domain.

Template 3: Cluster for Windows/Linux workloads with user customized compute node image in an existing Active Directory Domain

This template deploys an HPC Pack 2012 R2 cluster for Windows HPC workloads with user customized compute node image in an existing Active Directory Domain forest. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Windows compute nodes from user customized VM image. Use this template if you have a virtual network with Express Route configured and you want to join the cluster to your on-premises Active Directory Domain.

The following templates create an HPC Pack cluster in a new Active Directory Domain

Template 1: Cluster for Windows workloads

This template deploys an HPC Pack 2012 R2 cluster for Windows HPC workloads. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Windows compute nodes.

Template 2: Cluster for Linux workloads

This template deploys an HPC Pack 2012 R2 cluster for Linux HPC workloads. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Linux compute nodes. No public IP address is created for the virtual machines.

Template 3: Cluster for Windows/Linux workloads with user customized compute node image

This template deploys an HPC Pack 2012 R2 cluster with user customized compute node image. The cluster includes one head node with local databases (SQL Server 2014 Express version), and a configurable number of Windows compute nodes from user customized VM image.

Note:

It is an experimental feature to create the compute nodes as VM scale set. Some HPC features(for example ‘Azure auto grow shrink’) will not work if you use this feature.

About

Deploy an HPC cluster in Azure with Microsoft HPC Pack 2012 R2 Update 3

Документация

Сконфигурируйте для пакета HPC

Сконфигурируйте кластер для Microsoft HPC Pack

Следуйте за ними инструкция сконфигурировать вашу установку MATLAB ® Parallel Server™ , чтобы работать с Пакетом Microsoft ® HPC или Вычислить кластерный сервер (CCS). В следующих инструкциях, matlabroot относится к местоположению установки MATLAB.

Поддерживаемые версии: Windows ® Compute Cluster Server 2003, Windows HPC Server 2008, Windows HPC Server 2008 R2, Microsoft HPC Pack 2012, Microsoft HPC Pack 2012 R2 и Microsoft HPC Pack 2016.

Примечание

Если вы используете Пакет HPC в установке сетевого ресурса, местоположение сетевого ресурса должно быть в зоне “Интранет”. Вы можете должны быть настроить интернет-Опции для своих кластерных узлов и добавить местоположение сетевого ресурса в список интранет-сайтов.

Войдите в систему на кластерном главном узле как пользователь с правами администратора.

Откройте командное окно с правами администратора и запустите следующую команду файла

Эта команда выполняет часть настройки, требуемой для всех машин в кластере. Местоположение установки MATLAB должно быть тем же самым на каждом кластерном узле.

Примечание

Если необходимо заменить значения по умолчанию скрипта, измените значения, заданные в MicrosoftHPCServerSetup.xml прежде, чем запустить MicrosoftHPCServerSetup.bat . Используйте -def_file аргумент к скрипту при использовании MicrosoftHPCServerSetup.xml файл в пользовательском месте. Например:

Вы изменяете файл только на узле, куда вы на самом деле запускаете скрипт.

Пример одного из значений, которые вы можете установить, для CLUSTER_NAME . Если вы обеспечиваете дружественное имя для кластера в этом параметре, он распознан MATLAB, обнаруживают функцию кластеров и отображенный в получившемся кластерном списке.

Сконфигурируйте клиентский компьютер для пакета HPC

Это конфигурирование применяется ко всем версиям Пакета HPC.

Примечание

Если вы используете Пакет HPC в установке сетевого ресурса, местоположение сетевого ресурса должно быть в зоне “Интранет”. Вы можете должны быть настроить интернет-Опции для своих кластерных узлов и добавить местоположение сетевого ресурса в список интранет-сайтов.

Откройте командное окно с правами администратора и запустите следующую команду файла

Эта команда выполняет часть настройки, требуемой для клиентской машины.

Примечание

Если необходимо заменить значения по умолчанию скрипт, измените значения, заданные в MicrosoftHPCServerSetup.xml прежде, чем запустить MicrosoftHPCServerSetup.bat . Используйте -def_file аргумент к скрипту при использовании MicrosoftHPCServerSetup.xml файл в пользовательском месте. Например:

Чтобы представить задания или обнаружить кластер из MATLAB, клиентские утилиты Microsoft HPC Pack должны быть установлены на вашей клиентской машине MATLAB. Если они уже не установлены и не актуальны, попросите у своего системного администратора правильных клиентских утилит для установки. Утилиты доступны от центра загрузки Microsoft.

Если вы установили несколько версий клиентских утилит Microsoft HPC Pack, MATLAB использует новую установку. Чтобы сконфигурировать MATLAB, чтобы использовать определенную установку, установите переменную окружения ‘MATLAB_HPC_SERVER_HOME’ к местоположению установки клиентских утилит вы хотите использовать.

Подтвердите установку Используя Microsoft HPC Pack

Эта процедура проверяет, что ваши продукты параллельных вычислений установлены и сконфигурированы правильно для использования Пакета HPC Microsoft Windows или Вычислить кластерный сервер (CCS).

Шаг 1: задайте кластерный профиль

На этом шаге вы задаете кластерный профиль, чтобы использовать на последующих шагах.

Запустите Кластерного менеджера по Профилю с рабочего стола MATLAB путем выбирания On вкладки Home в области Environment Parallel> Manage Cluster Profiles.

Создайте новый профиль в Кластерном менеджере по Профилю путем выбора New> HPC Server.

С новым профилем, выбранным в списке, нажмите Rename и отредактируйте имя профиля, чтобы быть HPCtest . Нажмите Enter.

Во вкладке Properties предоставьте текст для следующих полей:

Установите поле Description на For testing installation with HPC Server .

Установите поле NumWorkers на количество рабочих, вы хотите запустить тесты валидации на, в рамках ограничения вашего лицензирования.

Установите поле Host на имя хоста, на котором запускается ваш планировщик. В зависимости от вашей сети, эта сила быть простым именем хоста, или этому придется быть полностью определенное доменное имя.

Примечание: следующие четыре настройки свойства ( JobStorageLocation , ClusterMatlabRoot , ClusterVersion , и UseSOAJobSubmission ) являются дополнительными, и должен быть установлен в профиле здесь, только если вы не запускали MicrosoftHPCServerSetup.bat как описано в Конфигурируют Кластер для Microsoft HPC Pack, или если вы хотите заменить установку, установленную тем скриптом.

Установите JobStorageLocation на местоположение, где вы хотите, чтобы задание и данные о задаче хранились. Это должно быть доступно для всех машин рабочего.

Примечание

JobStorageLocation не должен быть совместно использован продуктами параллельных вычислений, запускающими различные версии; каждая версия на вашем кластере должна иметь свой собственный JobStorageLocation .

Установите ClusterMatlabRoot на местоположение установки MATLAB выполняться машинами рабочего, как определено в Главе 1 инструкций по установке.

Установите поле ClusterVersion на HPCServer или CCS .

Если вы хотите протестировать представления задания SOA на кластере Сервера HPC, установите UseSOAJobSubmission на true . Если вы планируете использовать представления задания SOA со своим кластером, необходимо протестировать это сначала без представления SOA, то позже возвращают и тестируют его с представлением задания SOA. Значение по умолчанию определяется во времени выполнения на основе вашего планировщика.

До сих пор диалоговое окно должно быть похожим на следующую фигуру:

Нажмите Done, чтобы сохранить ваш кластерный профиль.

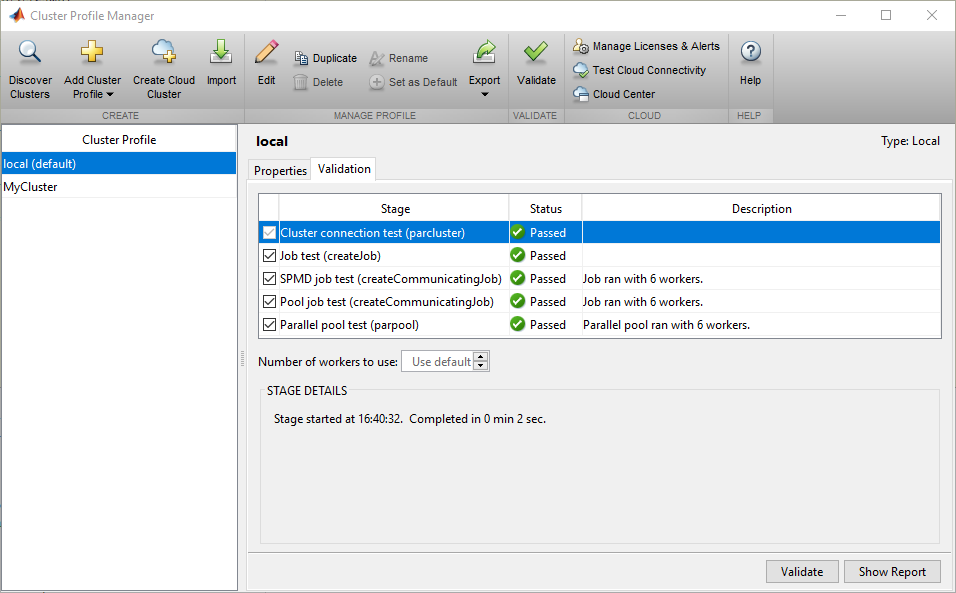

Шаг 2: подтвердите настройку

На этом шаге вы подтверждаете свой кластерный профиль, и таким образом свою установку. Можно задать количество рабочих, чтобы использовать при проверке профиля. Если вы не зададите количество рабочих во вкладке Validation, то валидация попытается использовать столько рабочих сколько значение, заданное NumWorkers свойство на вкладке Properties. Можно задать меньшее число рабочих, чтобы подтвердить настройку, не занимая целый кластер.

Если это не уже открыто, запустите Кластерного менеджера по Профилю с рабочего стола MATLAB путем выбирания On вкладки Home в области Environment Parallel> Manage Cluster Profiles.

Выберите свой кластерный профиль в листинге.

Кликните по вкладке Validation.

Используйте флажки, чтобы выбрать все тесты или подмножество этапов валидации, и задать количество рабочих, чтобы использовать при проверке профиля.

Вкладка Validation Results показывает выход. Следующий рисунок показывает результаты профиля, который прошел все тесты валидации.

Примечание

Если ваша валидация не передает, свяжитесь со службой поддержки установки MathWorks.

Если ваша валидация передала, у вас теперь есть допустимый профиль, который можно использовать в других параллельных приложениях. Можно сделать любые модификации к профилю подходящими для приложений, таких как NumWorkersRange , AttachedFiles , AdditionalPaths , и т.д.

Чтобы сохранить ваш профиль для других пользователей, выберите профиль и нажмите Export, затем сохраните ваш профиль в файл в удобном месте. Позже, при выполнении Кластерного менеджера по Профилю, другие пользователи могут импортировать профиль путем нажатия на Import.